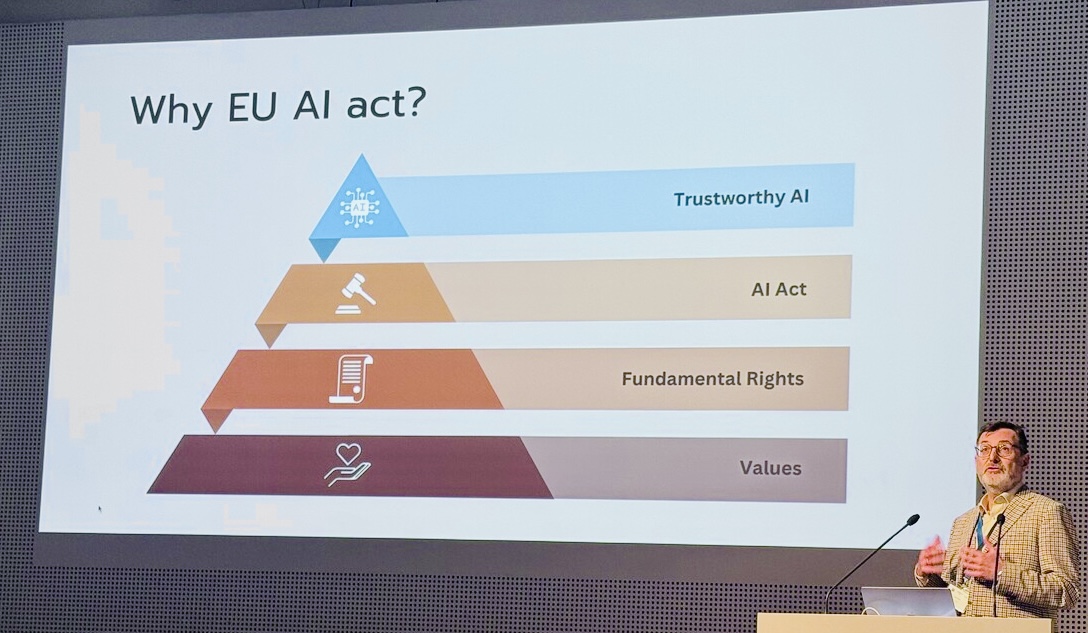

Künstliche Intelligenz entwickelt sich rasant und mit ihr die Sorge um Sicherheit, Fairness und den Schutz der Grundrechte. Als Antwort darauf hat die Europäische Union den EU AI Act verabschiedet – den weltweit ersten umfassenden Rechtsrahmen für Künstliche Intelligenz (KI). Sein Anspruch ist klar: sicherzustellen, dass in Europa eingesetzte KI-Systeme sicher, vertrauenswürdig und mit zentralen europäischen Werten vereinbar sind.

Doch obwohl der AI Act starke und notwendige Verpflichtungen formuliert, stehen viele Organisationen vor einem praktischen Dilemma: Wie lassen sich abstrakte Prinzipien – wie Würde, Autonomie oder Fairness – in konkrete Designentscheidungen während der Systementwicklung übersetzen?

Genau hier setzt Value-Based Engineering (VBE) an. Basierend auf dem IEEE-7000-Standard bietet VBE eine strukturierte und praxisnahe Methodik, um ethische Überlegungen systematisch in technische Entwicklungsprozesse zu integrieren. Teams erhalten Werkzeuge, um Stakeholder-Werte zu identifizieren, ethische Risiken zu bewerten und diese Erkenntnisse in umsetzbare technische Anforderungen zu überführen.

Vor diesem Hintergrund untersuchen Lukas Madl, Soner Bargu und Mert Cuhadaroglu von Innovethic in ihrem Paper „Bridging Ethics and Regulation: How VBE Facilitates Compliance with the EU AI Act in High-Risk and General Purpose AI“ genau diese Fragestellung. Der Beitrag ist im Open-Access-Band „Digital Humanism“ bei Springer erschienen – einer Sammlung begutachteter Texte über das Zusammenspiel von digitalen Technologien, Ethik, Recht, Gesellschaft und interdisziplinärer Forschung. Dieser Blogbeitrag fasst die Kernerkenntnisse des Papers zusammen und zeigt, was sie für Organisationen bedeuten, die vertrauenswürdige und rechtskonforme KI-Systeme entwickeln wollen.

Was der EU AI Act verlangt – und warum das herausfordernd ist

Der AI Act teilt KI-Systeme in vier Risikokategorien ein: minimal, begrenzt, hoch und inakzeptabel. Für Hochrisikosysteme gelten die strengsten Anforderungen – etwa zu Risikomanagement, Qualitätsmanagement, Daten-Governance, menschlicher Aufsicht, Transparenz und Dokumentation.

Das Paper weist jedoch auf mehrere praktische Herausforderungen hin:

1. Komplexe Risikoklassifikation

Insbesondere die in Anhang III gelisteten Anwendungen bilden praktische KI-Risiken nicht immer präzise ab. Das gilt besonders für General Purpose AI (GPAI), die vielseitig einsetzbar ist – sowohl zum Nutzen als auch zum Schaden.

Die Regulierung bewertet Systeme nach ihrer beabsichtigten Nutzung, doch GPAI kann in unvorhergesehenen Kontexten auftauchen.

2. Fehlende harmonisierte Standards

Die Konformitätsbewertung soll auf technischen Standards von CEN/CENELEC aufbauen. Viele dieser Standards existieren jedoch noch nicht. Organisationen wissen daher oft nicht, wie „Compliance“ praktisch aussieht – insbesondere beim Schutz der Grundrechte.

3. Rasante technologische Weiterentwicklung

Die Dynamik im KI-Bereich überholt die Regulierung regelmäßig. Zwar kann die EU einzelne Teile des Gesetzes per delegiertem Rechtsakt aktualisieren, doch praxisnahe Leitlinien hinken der Realität oft hinterher.

Entwicklungsteams müssen daher in einem Umfeld arbeiten, in dem Erwartungen unklar und Technologien ständig im Wandel sind.

Organisationen brauchen deshalb strukturierte Methoden, die vertrauenswürdige KI ermöglichen – selbst wenn Standards und Leitlinien sich noch entwickeln.

Wie VBE den EU AI Act ergänzt

Value-Based Engineering ist ein systematisches, lebenszyklusorientiertes Framework, um menschliche Werte über den gesamten Entwicklungsprozess hinweg zu identifizieren, zu analysieren und in Designentscheidungen einzubetten. Es umfasst unter Anderem: Concept & Context Exploration, Ethical Values Elicitation, Value-Based Design and Verification. Das Paper zeigt, dass VBE die Anforderungen des EU AI Act nicht nur gut ergänzt, sondern in vielen Bereichen darüber hinausgeht, indem es operative Schritte liefert, wo der Act nur Prinzipien formuliert.

Drei Bereiche sind besonders eng verknüpft:

1. Risikomanagement (Artikel 9)

VBE verlangt die Identifikation ethischer Risiken, die Bewertung von Wahrscheinlichkeit und Auswirkung, das Design von Maßnahmen und die Prüfung des Restrisikos – ein klarer Spiegel der Anforderungen an Hochrisiko-KI.

2. Qualitätsmanagement (Artikel 17)

VBE integriert sich nahtlos in bestehende QMS-Strukturen, indem es Ethical Value Requirements (EVRs) einführt: nachvollziehbare und testbare Anforderungen, die aus Stakeholder-Werten abgeleitet werden.

Das unterstützt Dokumentations-, Begründungs- und Aufsichtspflichten.

3. Grundrechts-Folgenabschätzung (Artikel 27)

VBE deckt durch Stakeholder-Analyse und Werteexploration automatisch Risiken hinsichtlich Würde, Autonomie, Privatsphäre, Gleichstellung und Fairness auf. Diese Erkenntnisse können direkt zur Erfüllung der FRIA-Pflicht (Fundamental Rights Impact Assessment) für Hochrisiko-KI genutzt werden.

Warum VBE sowohl ethische als auch regulatorische Compliance stärkt

Das Paper beschreibt vier Gründe, warum VBE nicht nur konformitätsfördernd wirkt, sondern auch den Geist des EU AI Act unterstützt.

1. Mehr als Prinzipien-Checklisten

Statische Checklisten wie „Fairness“ oder „Transparenz“ sind zu allgemein und werden leicht falsch angewendet.

VBE nutzt stattdessen einen nicht-listenbasierten Ansatz, der die kontextrelevanten Werte identifiziert. Dadurch werden blinde Flecken und „Checkbox-Ethics“ vermieden.

2. Tiefes Kontextverständnis

VBE verlangt die ethische Ausdifferenzierung von Werten (z. B. Würde, Autonomie) sowie die Einbeziehung von Stakeholder-Erfahrungen. Der tragische Fall eines Teenagers, der durch einen emotional manipulativen Chatbot zu Schaden kam, verdeutlicht, was passiert, wenn psychologische Sicherheit und Vulnerabilität nicht berücksichtigt werden. Solche Risiken werden durch eine Werteanalyse sichtbar – nicht erst nach der Markteinführung.

3. Strukturierte Wertidentifikation und Übersetzung in Technik

Die Übersetzung abstrakter Werte in testbare Anforderungen ist eine der größten Herausforderungen in der KI-Entwicklung. VBE löst dies mittels: Value Qualities, Ethical Value Requirements (EVRs) und nachverfolgbaren Designentscheidungen

So entsteht ein klarer, reproduzierbarer Weg, Ethik in technische Entscheidungen zu integrieren.

4. Frühzeitige und kontinuierliche Stakeholder-Einbindung

Vertrauenswürdige KI erfordert echte Auseinandersetzung mit den Betroffenen.

VBE bindet Stakeholder von Anfang an ein und bleibt über den gesamten Prozess hinweg in Kontakt – sodass reale Anliegen technische Entscheidungen prägen. Das reduziert Risiken, erhöht Akzeptanz und verbessert die Qualität des Systems.

Fazit

Die Umsetzung des EU AI Act ist nicht nur eine juristische Herausforderung – sie ist auch eine Engineering-Herausforderung. Organisationen brauchen Methoden, die gesetzliche Prinzipien in konkrete Designprozesse übersetzen. Value-Based Engineering bietet genau das.

Durch strukturierte Methoden für ethische Analysen, Risikobewertung, Einbindung von Stakeholdern und nachvollziehbare Anforderungsentwicklung hilft VBE dabei, KI-Systeme zu entwickeln, die nicht nur regelkonform sind, sondern tatsächlich mit menschlichen Werten und gesellschaftlichen Erwartungen übereinstimmen.

In einer Zeit, in der Vertrauen und Verantwortung zentrale Pfeiler der KI-Governance sind, ist VBE ein praxisnaher und zukunftsfähiger Ansatz für sichere, ethische und regulierungskonforme KI-Systeme.

Hier geht’s zum vollständigen Paper von Lukas Madl, Soner Bargu und Mert Cuhadaroglu.